Z interesującego nas najbardziej filmowego punktu widzenia największe wrażenie zrobił model Veo 3 potrafiący generować filmy z prawidłowo zsynchronizowanym dźwiękiem. Interesujące są także funkcje tłumaczenia na żywo w popularnym Google Meet oraz nowa generacja inteligentnych okularów XR i prototypowe nowe funkcje agentów AI aktywnie pomagających nam w codziennym życiu.

Veo 3: koniec niemych filmów AI

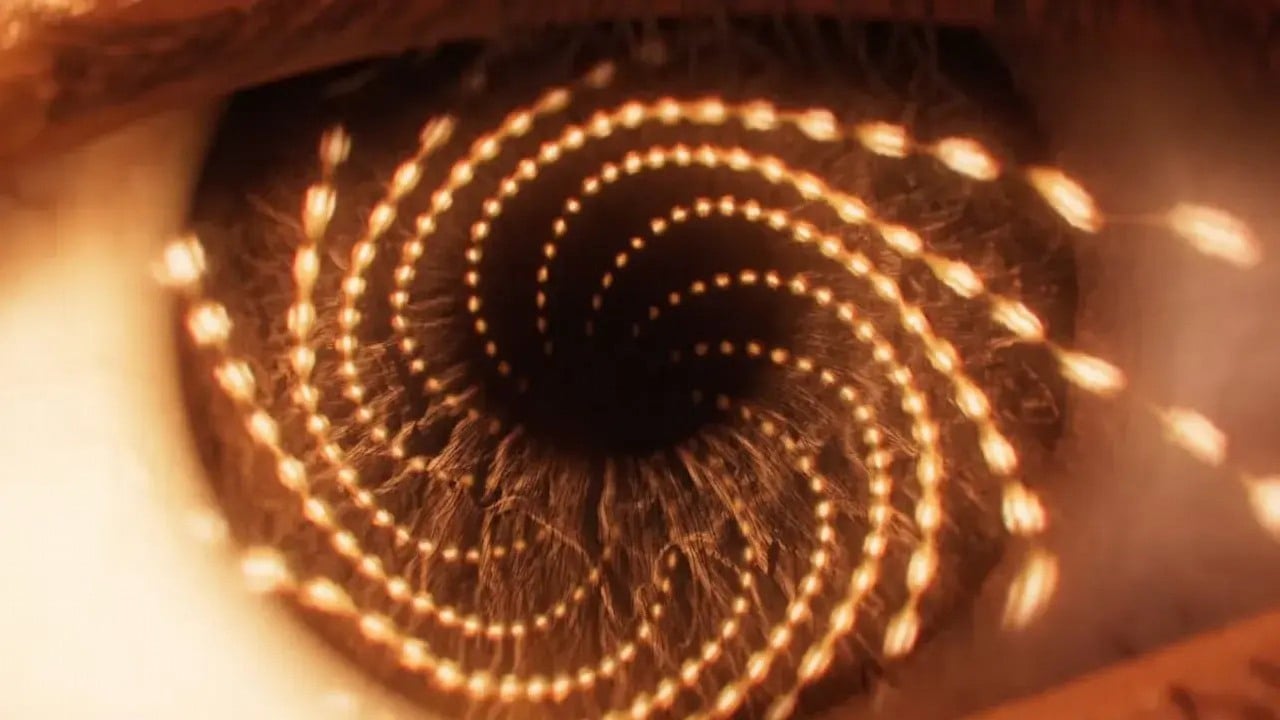

Veo 3 stanowi kolejny milowy krok w dziedzinie mediów generatywnych. W przeciwieństwie do poprzednich narzędzi do tworzenia filmów AI, które mogły generować tylko nieme klipy, Veo 3 tworzy zarówno wysokiej jakości filmy, jak i zsynchronizowany dźwięk — w tym dźwięki otoczenia, efekty, a choćby naturalnie brzmiące dialogi. Podczas demonstracji na żywo firma Google pokazała krótki klip z animowanymi zwierzątkami rozmawiającymi w lesie, z idealnie dopasowaną synchronizacją ruchu ust i dźwiękami otoczenia. Animatorzy mogą jeszcze spać spokojnie, z naciskiem na „jeszcze”.

Możliwości Veo 3 wykraczają poza proste ścieżki dźwiękowe. Użytkownicy mogą opisać scenę, określić nastrój, a choćby napisać dialogi. Veo 3 następnie ożywia tę wizję, dopasowując obraz i dźwięk z kinowym realizmem. Model doskonale radzi sobie z przestrzeganiem poleceń, odtwarzaniem realiów fizycznych i zapewnianiem spójności postaci i scen w wielu ujęciach. Nowe narzędzie Flow, stworzone specjalnie dla Veo, pozwala twórcom na iterację scen, ponowne wykorzystanie zasobów i tworzenie spójnych historii z niespotykaną dotąd łatwością.

Veo 3 jest już dostępne w Stanach Zjednoczonych dla subskrybentów kosztującego 250 dolarów miesięcznie pakietu Google AI Ultra za pośrednictwem aplikacji Gemini i Flow, a dla użytkowników korporacyjnych za pośrednictwem Vertex AI.

Tłumaczenie w czasie rzeczywistym: przełamanie barier językowych

Tłumaczenie językowe znalazło się w centrum uwagi podczas konferencji I/O 2025, podczas której Google zaprezentowało tłumaczenie mowy w czasie rzeczywistym między innymi w Google Meet oraz okularach XR.

Dzięki zaawansowanym modelom audio Gemini nowa funkcja wykracza poza tłumaczenie tekstu: tłumaczy mowę bezpośrednio na język słuchacza, zachowując ton i niuanse emocjonalne oryginalnego mówcy. Podczas prezentacji na żywo osoby mówiące po angielsku i hiszpańsku rozmawiały płynnie, słysząc słowa rozmówcy w swoim ojczystym języku, z naturalnie brzmiącym dubbingiem o niskim opóźnieniu.

Technologia ta jest wprowadzana w wersji beta dla subskrybentów Google AI Pro i Ultra, początkowo obsługując język angielski i hiszpański, ale niedługo pojawią się też kolejne języki. W okularach XR tłumaczenie na żywo pojawia się jako napisy w polu widzenia użytkownika, oferując „napisy dla prawdziwego świata” i ułatwiając wielojęzyczne rozmowy twarzą w twarz. Na razie pokaz nie do końca się powiódł i aplikacja się zawiesiła, ale niewątpliwie jesteśmy coraz bliżej uniwersalnego tłumacza niczym w Star Trek.

Okulary XR i gogle AR/VR: Gemini w polu widzenia

Wizja Google dotycząca rzeczywistości rozszerzonej (XR) zrobiła namacalny krok naprzód wraz z premierą Android XR — systemu operacyjnego stworzonego dla inteligentnych okularów i gogli w erze Gemini. Nowe okulary Android XR są lekkie, stylowe i wyposażone w kamery, mikrofony, głośniki i wyświetlacz w soczewkach. W przeciwieństwie do pierwszych modeli Google Glass sprzed dekady, te już wyglądają jak zwykłe okulary, łącząc technologię z modą – będą dostępne w oprawkach zaprojektowanych przez designerów z Gentle Monster i Warby Parker.

fot. Google

Podczas prezentacji na Google I/O 2025 zaprezentowano funkcje wysyłania wiadomości bez użycia rąk, nawigacji w przestrzeni, fotografowania oraz wspomnianego tłumaczenia w czasie rzeczywistym. Dzięki głębokiej integracji z Gemini okulary mogą odpowiadać na pytania dotyczące obiektów w otoczeniu, podawać wskazówki i wyświetlać informacje kontekstowe bezpośrednio w polu widzenia użytkownika.

Google zaprezentowało również nowe zestawy gogli AR/VR z systemem Android XR, obiecujące wciągające wrażenia „nieskończonego ekranu” i płynną pomoc AI za pośrednictwem Gemini.

Ekosystem Gemini rośnie i ewoluuje

Wszystko opisane powyżej, a także wiele więcej możliwie jest dzięki kolejnym aktualizacjom i rozszerzeniom modeli sztucznej inteligencji rodziny Gemini, które mają na celu uczynienie sztucznej inteligencji bardziej pomocną, inteligentną i spersonalizowaną.

Najnowszy model Gemini 2.5 Pro oferuje dalsze ulepszenia, w tym rozszerzone możliwości kodowania oraz nowy eksperymentalny tryb „Deep Think” przeznaczony do złożonych zapytań matematycznych oraz kodowania. W tym trybie model rozpatruje wiele możliwości przed udzieleniem odpowiedzi, ale początkowo będzie dostępny tylko dla wybranej grupy testerów. Gemini 2.5 Pro zajmuje w tej chwili pierwsze miejsce w rankingu LMArena we wszystkich kategoriach, co świadczy o szybkim postępie modelu. Deweloperzy mogą korzystać z Gemini 2.5 Pro w Google AI Studio, które oferuje teraz zintegrowany edytor kodu natywnego, umożliwiający szybsze tworzenie prototypów.

fot. Google

Gemini 2.5 Flash, zoptymalizowany pod kątem szybkości i wydajności, otrzymał aktualizację, która poprawia jego wydajność w zakresie kodowania i złożonych zadań wymagających rozumowania. Jest on teraz dostępny dla wszystkich użytkowników za pośrednictwem aplikacji Gemini. Google AI Studio i Vertex AI będą oferować obie wersje Gemini 2.5 Flash i 2.5 Pro w wersji zapoznawczej, a ogólna dostępność modelu Flash jest spodziewana na początku czerwca, zaś Pro niedługo potem. Gemini 2.5 Flash Native Audio w Live API umożliwia tworzenie aplikacji agencyjnych, które mogą słyszeć i mówić w 24 językach, lepiej rozumiejąc przebieg rozmowy, co zostało zaprezentowane w postaci tłumaczenia na żywo rozmowy poprzez Google Meet.

Najwyższy pakiet Google AI Ultra, dostępny jak na razie wyłącznie w Stanach Zjednoczonych w cenie 249,99 $ miesięcznie, zapewnia „najwyższy poziom dostępu” do aplikacji i usług Google opartych na sztucznej inteligencji, w tym wspomnianego wyżej generatora wideo Veo 3, nowej aplikacji do edycji wideo Flow oraz nadchodzącego trybu Gemini 2.5 Pro Deep Think. Subskrybenci otrzymują również wyższe limity w NotebookLM i Whisk, Gemini w Chrome, „agentów AI” opartych na Project Mariner, YouTube Premium oraz 30 TB przestrzeni dyskowej w chmurze.

Gemini Live integruje dane z aparatu urządzenia mobilnego i polecenia głosowe z funkcjami podobnymi do agenta AI, umożliwiając przeglądanie stron internetowych, wykonywanie połączeń i gromadzenie informacji. Rozszerza to poprzednie testy z Project Astra, umożliwiając sztucznej inteligencji interpretowanie obrazów uchwyconych przez aparat, zachowywanie informacji o otoczeniu i wykonywanie zadań i poleceń bez użycia rąk poprzez naturalną rozmowę z AI.

Wyszukiwanie na nowo dzięki trybowi AI

Wyszukiwarka Google przechodzi „największą jak dotąd aktualizację AI” wraz z wprowadzeniem trybu AI dla wszystkich użytkowników w Stanach Zjednoczonych. Ta nowa funkcja pozwala użytkownikom wyszukiwać informacje w Internecie dzięki chatbota Gemini AI, zaprojektowanego do obsługi bardziej złożonych zapytań.

Nowe funkcje testowane w trybie AI obejmują możliwości głębokiego wyszukiwania oraz generowanie wykresów dla zapytań dotyczących finansów i sportu. Tryb AI będzie również obsługiwał nowe funkcje zakupowe, takie jak wirtualne przymierzanie ubrań na podstawie jednego przesłanego zdjęcia i śledzenie obniżek cen wybranych produktów, a choćby dokonywanie zakupów, jeżeli wyrazisz na to zgodę. AI Overviews, podsumowania oparte na Gemini wyświetlane u góry wyników wyszukiwania, są według informacji Google oglądane przez ponad 1,5 miliarda osób miesięcznie.

Inne kreatywne narzędzia AI

Google zaprezentowało kolejne ulepszenia kreatywnych narzędzi opartych na sztucznej inteligencji, które mogą zmienić sposób pracy artystów i programistów.

Imagen 4, najnowszy generator obrazów na podstawie tekstu, oferuje ulepszone generowanie i możliwość eksportowania obrazów w różnych formatach. Może tworzyć bardziej skomplikowane detale, takie jak tekstury lub niestandardowe teksty.

fot. Google

Wprowadzono też nową aplikację do tworzenia filmów opartą na sztucznej inteligencji o nazwie Flow. Wykorzystując Veo, Imagen i Gemini, Flow może generować 8-sekundowe fragmenty filmów oparte na sztucznej inteligencji na podstawie tekstowych instrukcji lub obrazów. Zawiera również funkcje pozwalające łączyć wygenerowane przez AI klipy w dłuższe sekwencje. Użytkownicy mogą przesyłać obrazy postaci, rekwizytów lub scenerii i animować je lub generować wizualizacje bezpośrednio w Flow dzięki opisów.

Podsumowanie naEKRANIE

Konferencja Google I/O 2025 to wgląd w niedaleką przyszłość, w której generatywna sztuczna inteligencja i urządzenia XR łączą się, aby ułatwić komunikację i na nowo zdefiniować sposób, w jaki wchodzimy w interakcję z technologią. Od tłumaczenia rozmów na żywo, poprzez agentów AI robiących za nas zakupy po najlepszej cenie i załatwiających różne proste sprawy, aż po narzędzia generatywnej AI, jak Veo 3, które pozwolą wielu początkującym filmowcom postawić pierwsze kroki w posługiwaniu się uniwersalnym językiem kina. A także powstanie kolejnych wizualnych abominacji oraz fejków, ale jest to cena, którą Google jest skłonne zapłacić za rozwój swoich technologii.

fot. Google